Добро пожаловать!

Список цикла статей:

- Домашний Сервер: Часть 1 – Предисловие, аппаратная и софтовая начинка (вы тут)

- Домашний Сервер: Часть 2 – Установка системы виртуализации Proxmox

- Домашний Сервер: Часть 3 – Внутренний DNS сервис на BIND9 или свои доменные имена в локальной сети

- Домашний Сервер: Часть 4 – Настройка Transmission daemon в контейнере LXC Proxmox-VE

- Домашний Сервер: Часть 5 – Установка и настройка Plex Media Server в контейнере LXC Proxmox-VE

Подробности в апдейте в конце статьи!

Наконец я добрался до написания этой статьи. К ней я шел долгие два с чем-то года 🙂

Данным постом хотелось бы начать отдельный цикл статей, которые будут посвящены моим исследованиям в рамках реализации домашнего сервера и различных сервисов на нем.

Что это и зачем вообще меня понесло в эту сферу, я расскажу в этом посте и давайте начнем обо всем по порядку!

Так как меня достаточно сильно интересуют различные IT тематики, я озадачился вопросом сборки собственного домашнего сервера.

Безусловно в обычном хозяйстве такая вещь по сути избыточна, в самом простом примере все лежит на домашнем компе, если что нужно поковырять, то это можно сделать в рамках существующих мощностей.

Основной целью было создание хорошего медиа-сервиса для просмотров фильмов и сериалов, ибо моя медиатека через некоторое время забила два HDD до отказа, а это чуть более 2Тб!

За некоторый период я уже успел ознакомится с возможностями DLNA встроенных в ОС «Окна» и меня они не очень-то и радовали. Тем не менее мне удалось найти более чем классный сервис Plex (будет в отдельной статье) о котором вскользь упоминалось в статье Домашний Медиа-плеер: Raspbian + Kodi + плагин Plex на Raspberry Pi 3 B+

Но за реализацией основной цели скрывались цели о которых я раньше только догадывался! О них я узнавал по мере ознакомления с различным софтом и решениями на этом софте.

Итогом всей моей головоломки стала реализация сервера с системой виртуализации Proxmox и различными контейнерами с отдельными сервисами, о чем я постараюсь рассказать.

Данный пост это ни в коем случае не призыв делать аналогично, я просто хочу познакомить вас с тем, что вышло у меня и как я это все реализовывал. Может тоже захотите 🙂

Перво наперво нужно было определиться с железом, с софтом и тем, как это все будет работать в локальной сети!

Аппаратная часть

После долгих обдумываний и гуглежа было принято решение делать все на серверных компонентах, ведь подразумевалось, что сервер будет лопатить 365/24/7 с небольшими перерывами на профилактику.

А серверные компоненты стоят не дешево. Безусловно я изучал различные готовые решения типа QNAP, Synology и др., но меня они не устраивали по ряду причин. По цене, собственная сборка, получалась подороже конечно.

В принципе я был уверен, что молодые годы опыта по сборкам/разборкам ПК мне помогут, а повышенную цену компенсирует более мощная база )

Сказано сделано!

Далее необходимо было определиться с количеством места, используемой системой, потребляемыми ресурсами и др.

С чем же в итоге мне пришлось определиться? А вот с чем:

- Компактный корпус — формата ITX с местом для 2х дисков 2.5″ и 4х дисков 3.5″

- Motherboard — формата mini-ITX с 6 SATA портами 6Гбит/сек поддержкой CPU Xeon, серверной DDR-DIMM памяти с ECC. Не самая новая конечно, иначе будет слишком дорого.

- CPU — Самый дешевый серверный Xeon

- DDR — Оперативная память с ECC

- SSD — 2шт. в RAID-1

- HDD — 4шт. в RAID-5 (у многих на него бомбит)

- Блок питания — формата ATX на 550W

В принципе этого достаточно, чтобы понять, что не так просто такое найти и собрать в один сервер. Но у меня получилось 🙂

Давайте расскажу, что именно я выбрал пока искал необходимое.

Корпус

Корпуса я анализировал долго, это одно из самых не простых решений. Мне повезло и я урвал последний(на тот момент) корпус который подходил мне по всем параметрам.

Корпус: Chenbro SR301/69T3

Кратенько пробежимся по характеристикам:

- Форм фактор материнской платы: Mini-ITX 170 x 170(мм)

- Размер корпуса: 310 x 200 x 270(мм)

- Место для SSD: внутри для 2.5″ — 2шт.

- Место для SSD/HDD: внутри для 2.5″/3.5″ — 4шт. Съемные корзины. Горячая замена

- Охлаждение: один вентилятор 120мм под корзиной с HDD/SSD

- Питание: место под блок питания формата ATX с длиной не более 140 мм

Как видим в данном корпусе есть все, что требуется. И место для ITX материнской платы, и 6 дисков и их горячая замена и компактность, причем с местом для практически полноформатного ATX блока питания.

В принципе вы все еще можете найти данный корпус в рознице и прикупить его. Цена правда на него кусается: ~ 8 700 руб.(цена на момент написания статьи по поиску) Но хороший корпус для сервера, из хороших материалов того стоит.

Кстати в сети есть обзоры на этот корпус 🙂 Их я тоже смотрел.

Материнская плата

Конечно ядром всего этого безобразия выступает материнская плата. Где же найти такую красавицу с такими требованиями да еще и с серверными замашками?

Мне повезло по аналогии с корпусом, я урвал последнюю(на тот момент) плату. Знакомьтесь…

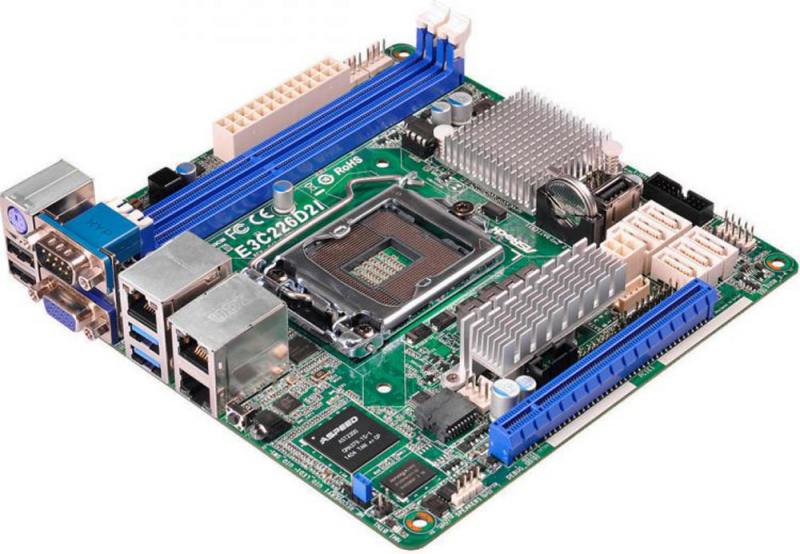

Motherboard: Серверная плата ASRock E3C226D2I (mini-ITX 6x6Gb SATA) — 1 шт.

Причем я приятно удивился, когда после покупки обнаружил её в официально рекомендуемых для купленного мной корпуса 🙂

В ней все хорошо, даже, как полагается, есть интерфейс IPMI (Intelligent Platform Management Interface) 2.0 для управления по сети (позволяет работать с BIOS без подключения монитора и клавиатуры!)

Как можно видеть, есть поддержка 6 SATA портов 6Гбит/сек для всего набора дисков и это главное. Ну.. помимо форм фактора еще.

Я выбрал специально не самый новый сокет в угоду стоимости и возможности найти CPU для неё за «не дорого».

Единичный сокет H3 (LGA 1150) с поддержкой 4й и 5й генерации Intel Xeon E3-1200 v3/v4/ Core™ i7/i5/i3/Pentium/Celeron Processors

Из минусов(если так можно сказать) это максимальный объем оперативной памяти не более 16GB. Мне этого в принципе хватит. По началу я использую 8GB

На текущий момент данная плата уже не продается в розницу. Урвал я её по цене 5 800 руб.

CPU

Само собой CPU. «Мозги» я рискнул поискать на AliExpress т.к. Intel Xeon E3-1200 v3 уже давно не флагман и появилось много б.у. экземпляров.

CPU: Intel Xeon E3-1220 V3 (3100MHz, LGA1150, L3 8Mb) — 1 шт.

Данный CPU 4 ядерный и поддерживает оперативную память DDR3 1333/1600 ECC

Сам CPU поддерживает максимальный объем оперативной памяти не более 32GB. Т.е. ограничителем выступает материнская плата.

Брал на Али по цене в 8 400 руб. На текущий момент(дата написания статьи) еще можно найти у нескольких продавцов.

CPU оказался с «падением» был виден отколотый уголок текстолита, но при этом он полностью рабочий. Проверен временем! Чего и следовало ожидать 🙂

DDR

По оперативной памяти все достаточно просто.

DDR3: 4Gb DDR-III 1600MHz Transcend ECC (TS512MLK72V6N) — 2 шт.

В целом по памяти рассказывать особо и нечего. Купил и поставил.

По цене одна планка DDR около 3 800 руб.(цена на момент написания статьи по поиску)

Охлаждение

Ку да же без охлаждения! Для этих целей был необходим компактный кулер т.к. корпус компактный и при этом формат блока питания практически полноразмерный ATX(с некоторым ограничением по длине не более 140 мм).

Я подобрал кулер исходя из замеров. И еще взял к этому всему мою любимую термопасту.(вам может быть нравится другая, но я полагался на свой давний опыт сборщика)

Кулер: ID-COOLING IS-40V3

Термопаста: Arctic Cooling MX-2 4 г

Термопасту показывать не буду )

Высота профиля и вентилятора хорошая, сам вентилятор не шумный.

На текущий момент этот Кулер к сожалению уже не продается в розницу. Брал по цене около 1 200 руб.

SSD

С SSD вышла казусная ситуация… Вроде бы серверные компоненты все дела, а вот серверный SSD конечно имел достаточно серьезный ценник. И я позволили себе вольность.

Я выбрал SSD ориентируясь на доступную цену и достаточно хорошие отзывы(видимо зря).

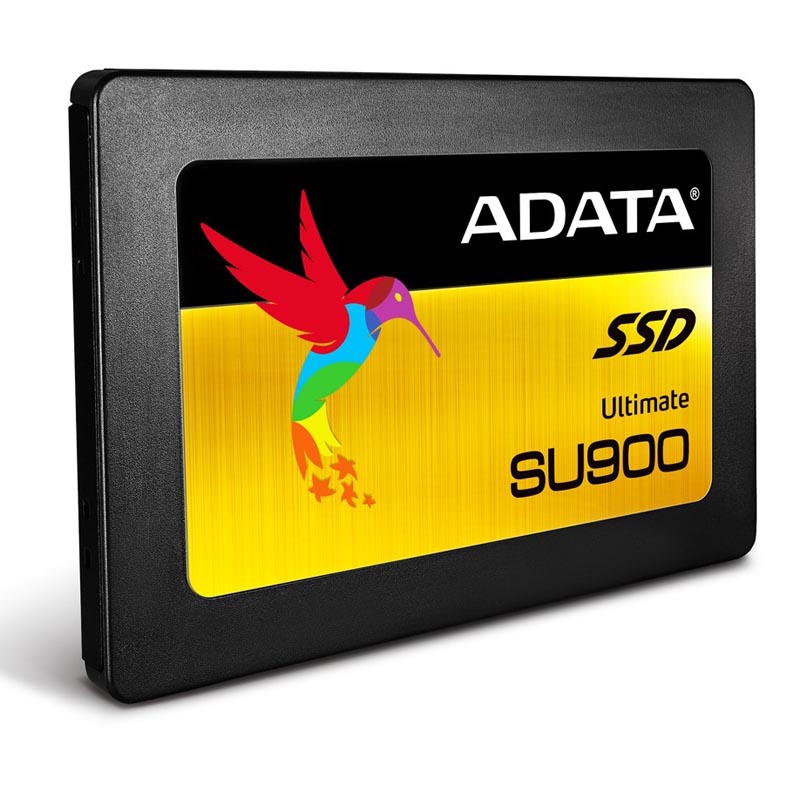

SSD: 256Gb SSD A-DATA Ultimate SU900 (ASU900SS-256GM-C) — 2 шт.

Собственно именно они были изначально поставлены и использовались под отладку рабочей конфигурации, но потом один отвалился и следом за ним второй. Результатом оказалась не стабильная прошивка, которую A-DATA использовала в своих SSD, причем обновлять её они не спешили. Благо использовался популярный чип и мне удалось разобрав SSD, замкнув пару контактов перевести его в режим прошивки. Найдя на китайских просторах более новую прошивку и саму программу для прошивки мне удалось восстановить работоспособность данных SSD и (тфу, тфу, тфу) пока работает без нареканий.

Но гарантия на них, после таких манипуляций, как бы все… Будьте внимательны! Берите устройства только надежных производителей!

По цене один SSD около 4 100 руб.(цена на момент написания статьи по поиску)

HDD

С HDD я решил пойти по пути выбора специализированных решений для NAS. Выбирал среди популярных игроков и выбрал таки после долгих раздумий и анализа цен.

HDD: 3Tb — Seagate IronWolf NAS ST3000VN007 — 4 шт.

Тут ничего удивительного нет. Единственное, что хочется отметить так это использование 4-х HDD в конфигурации RAID-5, т.е. теоретически это будет 9Тб места под данные, остальное под хеш и все такое. На просторах интернета по этому поводу много холиваров и в целом я согласен с рисками в продакшене. Пока мне для дома этого вполне достаточно, посмотрим как все это будет проявлять себя на практике, (тфу, тфу, тфу) пока работает без нареканий.

По цене один HDD около 7 000 руб.(цена на момент написания статьи по поиску)

Блок питания

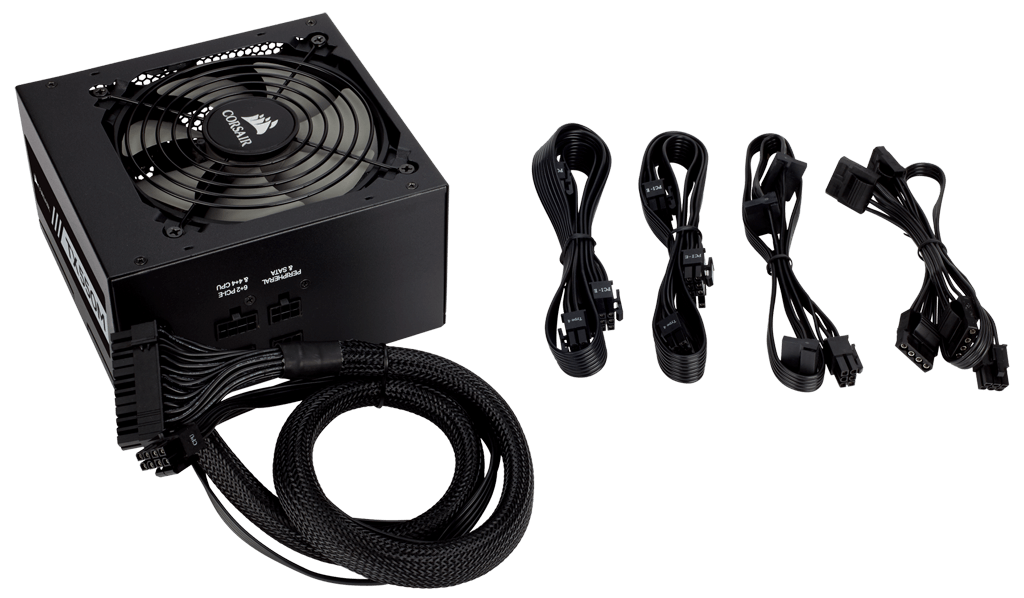

Нужно же подать питание в такую систему и озаботиться тем, чтобы оно было качественным и стабильным. Непосредственно в корпусе за это отвечает блок питания. И в этом решении он полноразмерный формата ATX. Но с одним ограничением! Т.к. блок питания прикручивается розеткой вверх(да да, позиционирование не простое), его нижняя часть с кабелями упирается в материнскую плату, именно поэтому тут требуется, чтобы его длина не превышала 140 мм. Благо на рынке такого добра достаточно. Выбор пал на:

БП: 550W Corsair TX550M (CP-9020133-EU)

Данного блока питания хватит с запасом. Я посчитал ориентировочное потребление всей системы по доступной документации на основные узлы и у меня получилось что-то вроде: 168W

Этого хватит с запасом и блок питания не будет работать на максималках, что в свою очередь сбережет его.

По цене БП около 6 200 руб.(цена на момент написания статьи по поиску)

Бесперебойное питание

А куда же без ИБП. Для обеспечения бесперебойной работы одного качественного блока питания не достаточно, необходим еще и бесперебойный блок питания.

Я специально добавил его в эту статью, чтобы все понимали необходимость резервирования. Иначе кратковременные отключения могут повредить системе работающей 365/24/7

Выбор пал на ИБП: APC Back-UPS 650VA 390W BX650CI-RS

Дополнительно к бесперебойнику еще подключен роутер MikroTik hEX S, а к роутеру еще по PoE подключена точка доступа MikroTik hAP ac

По цене ИБП около 5 600 руб.(цена на момент написания статьи по поиску)

Софтовая часть

Выбирая на чем реализовывать всю основную работу софтовой части я сразу начал рассматривать такой интересный проект, как Proxmox Virtual Environment (Proxmox VE) — система виртуализации с открытым исходным кодом, основанная на Debian GNU/Linux. Благо по работе я успел изучить её достаточно глубоко и знал на что иду.

Выдержка из Wikipedia:

Управление виртуальными машинами и администрирование самого сервера производятся через веб-интерфейс либо через стандартный интерфейс командной строки Linux.

Для создаваемых виртуальных машин доступно множество опций: используемый гипервизор, тип хранилища (файл образа или LVM), тип эмулируемой дисковой подсистемы (IDE, SCSI или VirtIO), тип эмулируемой сетевой карты, количество доступных процессоров и другие.

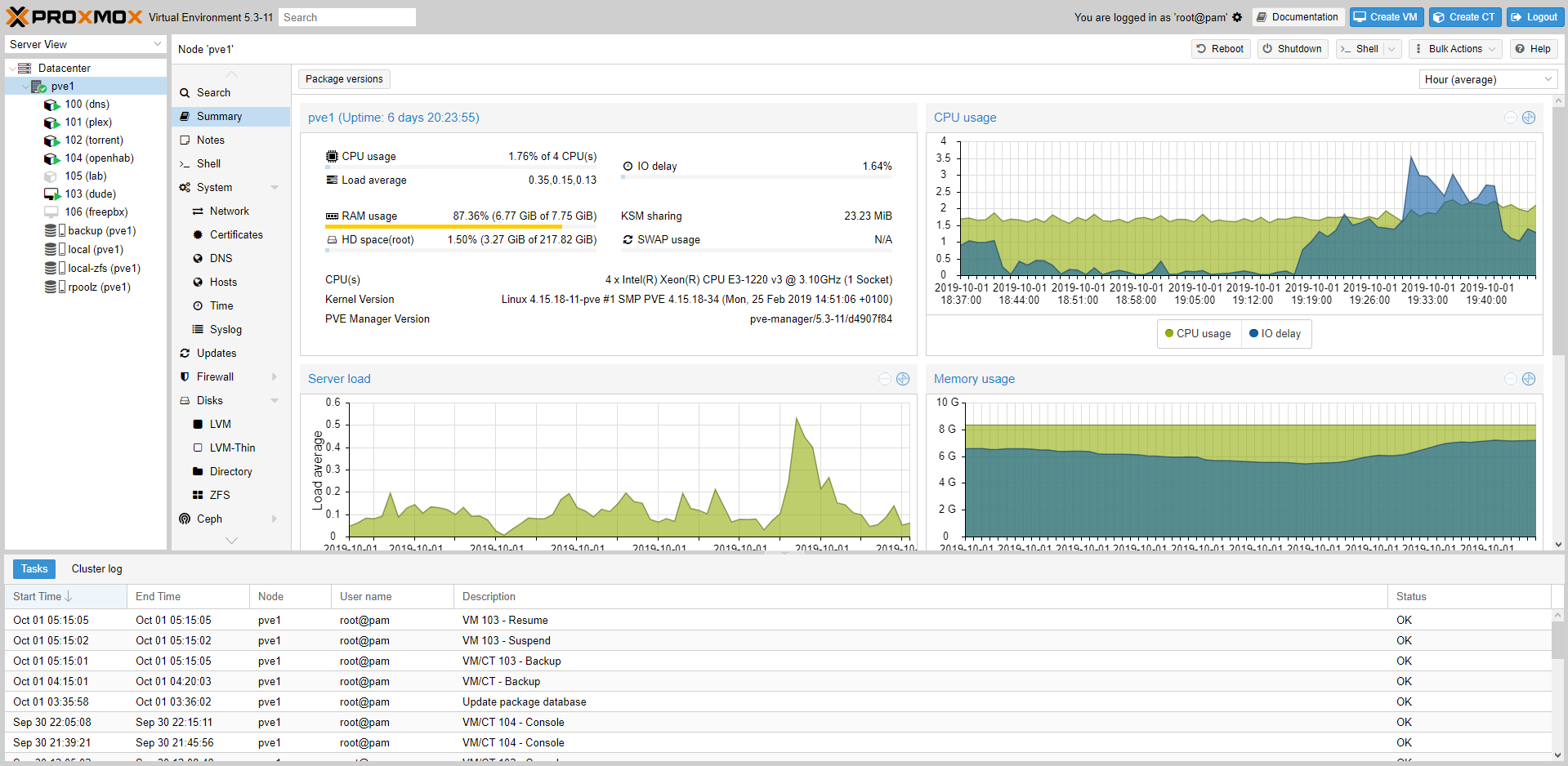

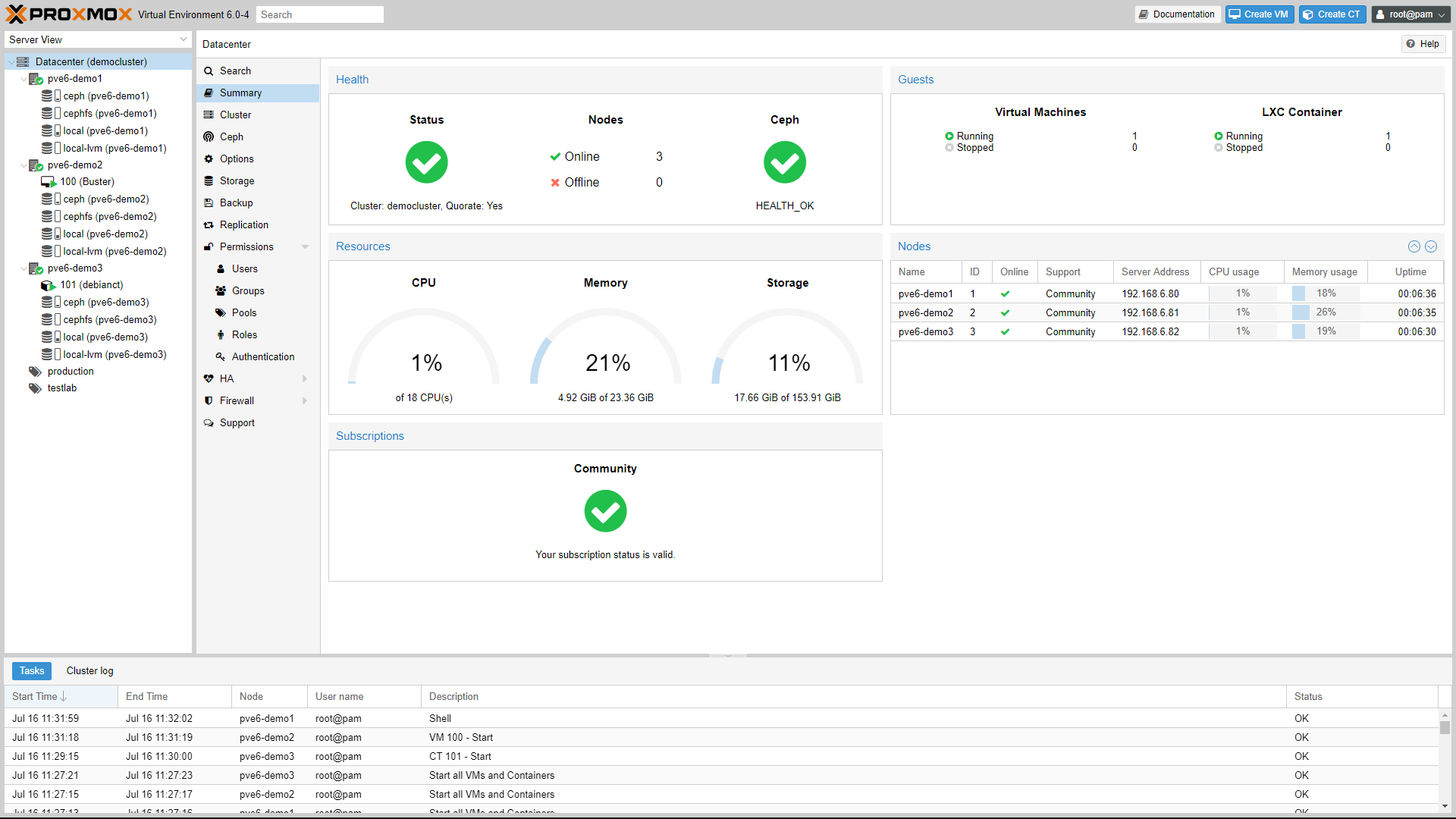

И немного картинок:

Данная система виртуализации позволит создать распределенную систему с различными сервисами, бекапами, софт RAID и другими плюшками.

Заключение… Продолжение?

В итоге получается достаточно компактная и мощная(для дома или малого офиса) система. Отдельные NAS системы от именитых производителей могут обеспечить практически такие же возможности, но там работает проприетарная ОС, к которой можно доустановить ряд модулей и сервисов. В моей же идеологии это самостоятельная система которую я могу дорабатывать и улучшать в рамках возможностей выбранного железа и софта.

Для чего же мне в итоге понадобится такая система? Ведь не для простого эстетического удовлетворения? Конечно нет!

Просто приведу список того, что у меня уже реализовано или же в процессе изучения и проработки:

- DNS — доменные имена в локальной сети вместо IP адресов. Домашний Сервер: Часть 3 – Внутренний DNS сервис на BIND9 или свои доменные имена в локальной сети

- Torrent Transmission — качалка торрентов. Домашний Сервер: Часть 4 – Настройка Transmission daemon в контейнере LXC Proxmox-VE

- Plex Mediaserver — домашний медиа сервер. Домашний Сервер: Часть 5 – Установка и настройка Plex Media Server в контейнере LXC Proxmox-VE

- The Dude — мониторинг девайсов в домашней сети.

- Умный дом, домашний IoT.

- IP телефония.

Далее я планирую описать реализацию интересных пунктов из этого списка. Следите за обновлениями!

Кстати по цене вы могли посчитать, что все это в рамках двухлетней сборки обошлось мне около: 80 000 руб., что в среднем по 3 333 руб в месяц.

А на чем вы собрали, планируете собирать или еще только продумываете себе подобное решение? Пишите в комментариях!

Благодарю за ваше время!

Всего хорошего на просторах Интернета 😉

UPD: 03.02.2023 (добавление M.2 NVME SSD)

В конфигурацию добавлен M.2 NVME SSD накопитель для реализации L2ARC кэша и ZIL кэш логов записи.

Подробнее в соответствующей статье: Домашний Сервер: Часть 2 – Установка системы виртуализации Proxmox

UPD: 21.10.2022 (восстановление сервера)

Где-то в середине 2021 года длительное отключение электричества привело к неприятной ситуации — сервер перестал запускаться. Сервер пришлось жёстко выключить т.к. он перестал реагировать. Бесперебойник тут не при делах. После первичной диагностики удалось понять, что виной всему материнская плата. Видимо та самая ситуация которую описывал Дмитрий в комментариях.

И вот в конце 2022 года, я таки сподобился реанимировать свой сервер (до этого всё запускал на Raspberry Pi — такое себе если честно)

Мне повезло найти б/у серверную материнскую плату Asus P10S-i, но это повлекло за собой замену CPU и памяти соответственно. Итак новый сетап:

- Материнская плата: Asus P10S-I (Ссылка)

- Процессор: Intel Xeon E3-1280 v5 (Ссылка)

- Оперативная память: Kingston 8 ГБ DDR4 3200 МГц CL22 (KSM32ES8/8HD) — 2шт.

Кулер подошел изначальный.

Бонусом достался кабель mini-SAS HD для подключения тех самых 4х дисков.

На удивление после подключения всех компонентов система запустилась без каких либо проблем. Вот что значит преимущество создания программных RAID массивов. Оставалось обновить Proxmox и контейнеры до последних версий, что также успешно было исполнено.

Всем добра и беспроблемной работы ваших систем 😉

я откровенно не в теме. хочу попрбовать proxmox на том что есть — маленький старый оптиплекс микро. реально это максимум два диска один ссд и один обычный 2.5. Как к этому хозяйству прикрутить nas qnap? если можно ссылку, поробую разобраться. спасибо

Proxmox Вы можете попробовать без проблем. А вот что Вы имеете в виду под «прикрутить nas qnap»?

Григорий, добрый день!

Спасибо за цикл интересных статей!

Подскажите, пожалуйста, по вопросу целесообразности (в плане избыточности) использования 2-х SSD-дисков по 250 Гб в ZFS Raid-1 зеркале — на сколько оправдано использование именно 250 Гб дисков, а не дисков меньшего объема? 1. Сколько места на основном диске занимает хост-система (Proxmox + Debian), а также, остальные гостевые ОС (контейнеры), которые вы используете, шаблоны для гостевых ОС, их бэкап-файлы контейнеров, виртуальных машин и т.д. ?

2. На сколько процентов использовался ваш SSD диск в зеркале Proxmox со всеми контейнерами и виртуалками для ваших нужд после установки и через год после использования ?

Строю аналогичную вашей конфигурацию но вот думаю, не переплатил ли я за 250-гигабайтные диски или для домашних нужд вполне хватило бы 64 Гб (их, конечно, уже не найти в продаже) или, что более оптимально, 128-150-гб диски. На просторах интернета, почему-то, этот вопрос мало освещен.

К вопросу выше забыл добавить, что в качестве хранилища будут использоваться 6 HDD дисков по 2 Тб в Raidz1.

И думаю, что виртуальные машины, образы, бэкапы целесообразно хранить на этом хранилище.

Здравствуйте, благодарю за интерес и спасибо за комментарий! Постараюсь ответить.

Мое мнение, что 2 штуки по 250(256) Гб в самый раз. 120(128) Гб тоже в принципе норм, но я люблю немного делать с запасом. Дело не только в том, что у вас много места, а в самом принципе работы SSD дисков и контроллеров в них.

Некоторые SSD обеспечивают максимальную скорость при объемах 50,60% от того, что есть. Также есть такие понятия, как деградация ячеек памяти и переразметка ячеек контроллером. Для такой переразметки используются как раз незадействованные блоки, но там нужно смотреть разметку и т.д. Это может позволить даже относительно бюджетному SSD проработать очень долго.

Сама система занимает не много, что-то в районе 3Гб, вместе с системой идут шаблоны, виртуалки и снапшоты. Они располагаются на rpool и занимают сейчас около 20 Гб.

Под бекапы я сразу выделил место на raidz1(он же rpoolz). Они сейчас занимают 2 Тб. Под каждый контейнер выделяется по 5 бекапов.

У меня 9 активных контейнеров, 2 не активных и 1 не активная виртуалка.

Если честно я даже не задумывался сравнивать т.к. различные контейнеры я подключал по мере необходимости тех или иных сервисов в течение всего жизненного цикла системы.

Григорий, приветствую!

Хотел поинтересоваться как у Вас поживает материнка ASRock E3C226D2I? Свой второй домашний сервер я тоже собирал на ней и как раз под пятый Proxmox. IPMI, конечно, очень удобная вещь. Но со временем начал проявляться один неприятный глюк — после снятия питания она отказывалась стартовать, помогало только передёргивание батарейки BIOS. Отдал в ремонт по гарантии, но сделать так и не смогли — вернули деньги. Купил вторую с рук на Авито новую. Пол года всё Ок, потом снова та же песня, причём симптоматика один в один. Сначала всё прекрасно. Через какое то время начинаются проблемы с включением после выключения питания, нужно подождать минут 15. Через месяц интервал увеличивается и далее вовсе перестаёт включаться, только с помощью вытаскивания батарейки. В Инете нашёл описание множества аналогичных случаев, в т.ч. и на Авито часто встречаются данные платы с такой проблематикой — https://www.avito.ru/moskva/tovary_dlya_kompyutera/asrock_e3c226d2i_lga1150_mini-itx_ne_rabochaya_1893628436.

Приветствую!

Хм, интересно. На текущий момент я с такой проблемой не сталкивался. Возможно просто потому, что сервер у меня перезагружался только во время настройки и потом уже только во время длительного отключения электричества один раз.

Все остальное время у меня сервер работает постоянно и без перезагрузок (ведь именно для этого нужны серверные компоненты — Uptime 92 days)

И еще я сразу ставил последний BIOS, не знаю правда влияет это как-то или нет на ситуацию.

Уже понял, что только виртуалка. Да, хорошо что на сайте Proxmox есть видео по установке win 2016. Оказывается нужно драйверы подсовывать для сбалансированной работы — было большим сюрпризом для меня. Около часа потратил на это. Спать хочется -:)

Я на local storage ставлю. Или нужно под виртуалки на другое хранилище ставить? На видео указано iso-templates в качестве storage.

Тип хранимых данных зависит от типа созданного хранилища.

Например у меня используются Directory и ZFS, соответственно распределение такое

local: /var/lib/vz — Disk image, ISO image, Container template

local-backup: /rpoolz/root/backup — VZDump backup file

local-zfs: rpool/data — Container

Если Server 2016 нужно поставить, наверное лучше на виртуалку?

В LXC ставятся только Linux среды т.к. контейнеры работают через ядро хост системы и используют аппаратные ресурсы практически напрямую.

Все что не Linux или Linux, но с каким-то специфическим ядром и функционалом, то тут только виртуалка. Отсюда «винды» в Proxmox только под виртуалкой.

Вы смотрю на контейнеры подсели. А почему не виртуалки?

Потери ресурсов меньше т.к. LXC встроена в ядро изначально, ну а виртуалка это виртуалка.

И еще один плюс в том, что пространство контейнера доступно через файловую систему хоста.

В итоге посмотрел Proxmox. Понравилась, на ней и остановился -:)

Установка действительно очень простая.

Я пробовал даже ставить её на чистый Debian, но базовая установка с образа много проще 🙂

Сравнение виртуальных машин есть на просторах интернета. Вы ведь наверняка работали с DNS в Windows Server, но для дома выбрали другое решение. И скорее всего сделали осознанный выбор. Собственно мой вопрос заключался именно в этом. Опять же, смена платформы виртуализации куда более трудоёмкий процесс, чем замена того же медиасервера, например. Вы пишите о том, с чем работаете и это очень хорошо. Но есть и другие решения — не хуже и не лучше, они просто другие. Например, на apple TV у меня установлен Infuse, правда я покупал его. Хотя это клиентское приложение, оно так же подтягивает метаданные из интернета с информацией о фильме. Возможно настройки там не такие гибкие, как описанные вами в Plex, зато все работает из коробки как в Proxmox -:)

Григорий, прежде всего спасибо за развернутый ответ.

У меня есть NAS Synology с четырьмя дисками по 4 ТВ, объединенных в пятый RAID. Фильмы в 4К, плюс бэкапы двух моих компьютеров под МАС OS, яблочных устройств семьи и файлопомойка, заполнила этот массив на 90 процентов. Два года назад думал, что на лет пять точно хватит такого объема дисков, но увы.

Собственно сегодня получи компоненты для самосбора второго хранилища, плюс поиграться в виртуализацией. Как и Вы, выбрал серверные компоненты, но памяти с запасом — 64 ГБ (кстати менее 20 тысяч вышло (ЕСС+REG)) и сетевой интерфейс 10 Гигабит на борту МВ (Вот МВ с интегрированным процессором в разы дороже вашей сборки). Корпоративный рынок уже во всю 40 ГБ осваивает, в топовых десктопных материках повсеместно 10 Гигабит присутствует. Переход — вопрос времени.

По виртуалками надеялся получить более обстоятельный ответ. Год назад познакомился с ESXI, мне хватило недели, чтобы изучить ее возможности для дома и семьи. К слову версия 6.7 работает превосходно и не доставляет никах хлопот. На новую сборку хотел установить Proxmox или Hyper-V. Скорее всего второй вариант попробую. Он бесплатный, что странно для Майкрософт и пришел из корпоративного сегмента = надежность. Я уже почти созрел на Proxmox, но при скачивании с их сайта дистрибутива, обратил внимание на предложение купить поддержку годовую за совсем немалые деньги, Сейчас я могу и не покупать, но что будет год спустя?

Спасибо за информацию 🙂

Боюсь более развернутого ответа не смогу предоставить. Вы вероятно ожидали какого-то сравнения, почему то, а не иное.

В рамках ознакомления я использовал и ESXI и Hyper-V, но это было уже давно, текущая ситуация может сильно отличаться от моих ранних знаний, потому я и не берусь сравнивать эти системы.

Я знаком с Proxmox с 3 версии, а сейчас на секундочку уже 6-я. И можно с большой долей вероятности сказать, что через год будет тоже самое.

В оплату входит техническая поддержка и доступ к специальному enterprice репозиторию, не более того. При этом, если ничего не оплачивать и не подключать, никакой функционал не урезан и ей можно пользоваться абсолютно бесплатно в полной мере.

Я не сторонник перепрыгиваний с одного на другое. Домашний сервер один и изменять что-то в нем достаточно рискованно, а на вторую машину у меня пока нет ресурсов.

Добрый вечер Григорий.

Несколько лет читаю опубликованные вами статьи.

Поддерживаю Ваш выбор в сторону серверного железа, но, на мой взгляд, есть два ограничения, которые повлекут смену платформы в будущем. Речь про ограничения в оперативной памяти и сетевом интерфейсе. Для визуализации 16 гигабайт не так уж и много, если запускать несколько виртуальных машин. Для дома это не так актуально, но вдруг понадобится. Тем более, что цена оперативки сейчас вполне гуманна. Второй момент — я бы смотрел в сторону 10 гигабитной сети. Актуально для 4К видео, например. Тут конечно можно и сетевой адаптер прикупить, но занимаем единственный слот PCI. Это так, мысли в слух. Сам выбирал для себя подобное решение. Ещё очень интересует по каким критериям Вы выбрали KVM в качестве виртуалики. Под описанные вами задачи также хорошо подошли бы, например, ESXI и Hyper-v, которые так же бесплатны, подчеркну, под указанные задачи. Удачи и новых статей, хороших и разных -:)

Кирилл,

По поводу оперативной памяти я с вами полностью согласен, чем больше тем лучше. Самое разумное это сразу брать под поддерживаемый потолок CPU/Motherboard

По поводу 10 Гигабитной сети, то не соглашусь с вами, а вот почему. На практике 4K смотрится на одном источнике и давайте взглянем на битрейт который будет занимать, какой-нибудь «жирный» фильм в 4K и 4K трансляция Youtube:

Фильм: HEVC/H.265, 3840x2160p, (16:9), 54,4 Мбит/сек, 23.976 fps — общий поток 93.7 Mbps и это я взял самый жирный фильм на 119 Gb. Обычно смотрят меньше. Есть и фильмы с общим потоком в 130 Mbps при меньшем размере (115 Gb)

Трансляция Youtube в 4K: Битрейт видео, стандартная частота кадров (24, 25, 30) — SDR 35–45 Мбит/c, HDR 44–56 Мбит/с | Битрейт видео, высокая частота кадров (48,50,60) — SDR 53–68 Мбит/c, HDR 66–85 Мбит/с

(источник https://support.google.com/youtube/answer/1722171?hl=ru)

Даже не знаю, где в мультимедиа может пригодиться 10 Гигабитный канал с такими показателями.

Единственное если у вас еще дополнительно подключено внешнее NAS хранилище, чем шире канал тем быстрее обмен и 10 Гигабит сможет себя оправдать, но не более того.

ESXI и Hyper-v безусловно подошли бы, но меня подкупила простота эксплуатации Proxmox. Да и опыт её использования на работе у меня уже был, потому на нем и остановился.

То есть Вы установили 2 «домашних» SSD в Raid-1 (зеркало) под Linux? встречал заметки о отсутствии профита такой конфигурации, Ваше мнение?

Владимир, здравствуйте!

Благодарю за интерес к посту )

Мое мнение такое:

SSD в RAID-1 имеет смысл использовать для отказоустойчивости. Существует вероятность выхода из строя SSD не по причинам износа ячеек памяти. Да и износ ячеек памяти пока достаточно «мифическая» причина.

Если рассматривать скоростные характеристики, то тут понятно, что RAID-1 не для этого.

Если рассматривать надежность хранения данных, то тут необходимо применять бекап хост системы куда-либо еще. В любом случае RAID это не панацея от всех «болезней» и грамотный подход подразумевает грамотный бекап важных данных.

Именно поэтому я не стал покупать «серверные» SSD. Тут достаточно и простых SSD.

Правда глядя на криворукость некоторых производителей я бы взял чуть дороже решение от Samsung или Intel 🙂

Пока наблюдаю за ADATA после перепрошивки.